计算机视觉领域世界三大顶会之一的CVPR 2021论文接收结果于近日出炉,接收率约为27.3%,竞争十分激烈,腾讯安全研究团队Blade Team以其在AI安全领域的突破性发现成功入选。

此次腾讯Blade Team被收录的论文题为《MagDR:Mask-guided Detection and Reconstruction for Defending Deepfakes》,首次公开了一种能够消除对抗样本对Deepfake的干扰攻击的方法,该方法为防止深度伪造能力的滥用提出了创新思考。同时,该发现也能用于提升AI图像处理的安全性。

论文链接:https://arxiv.org/abs/2103.14211

Tencent Blade Team由腾讯安全平台部成立,专注于人工智能、移动互联网、物联网、云虚拟化等前沿技术领域的前瞻安全技术研究,目前已向Apple、Amazon、Google、Microsoft、Adobe等诸多国际知名公司报告并协助修复了200多个安全漏洞。

近年来,“AI变脸”特效风靡全球,近期爆红的“蚂蚁呀嘿”再次掀起体验和讨论的热潮,这种源自人工智能生成对抗网络的新技术,能够利用深度学习技术识别并交换图片或视频中的原始人像,不仅制作过程简单,而且逼真度惊人,几乎能达到以假乱真的效果。

Deepfake作为一项技术工具,有广泛的应用空间。语音合成能让计算机用人类的声音说出上百种语言,视频合成能让《速度与激情》里的Paul Walker复生,但若被滥用,也将带来巨大的风险,对身份识别和社会信任带来挑战。

那么,既然能用技术“造假”,能否用更强有力的技术去对抗?此前行业有研究显示,在源图像中加入人眼无法感知的对抗攻击,就能够通过对抗噪声来干扰Deepfake图像的生成结果,也就是说,通过在原图中加入人眼看不到的噪声,换脸模型就无法生成正确人脸了。

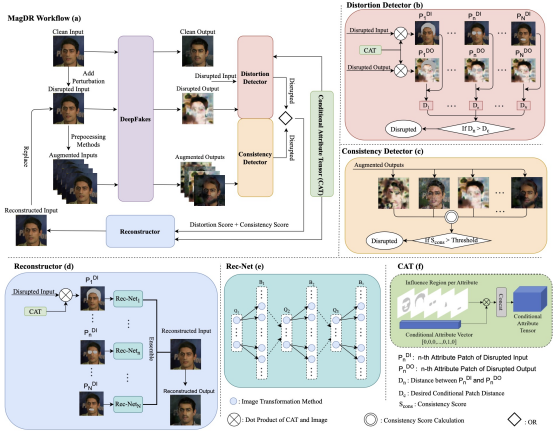

但这一对抗手段近期被证明仍有风险。腾讯Blade Team提出了一个全新的MagDR(mask-guided detection and reconstruction)的二阶段框架。其核心思想在于使用一些非监督性指标,对对抗样本在Deepfake中所生成的结果进行敏感性的评估,并且利用人脸属性区域作为辅助信息以及通过对最优的防御方法进行搜索组合的方式对图片进行检测和重建,以期望能够达到净化原图并保持Deepfake输出真实性的目的。

论文显示,腾讯安全研究员选取了Deepfake中较为重要的三个任务进行攻防实验,分别为换脸、人脸属性修改以及表情变换。给原图增加噪声后,所产生的对抗样本尽管对原图进行了修改,但修改的程度明显低于人眼可察觉的水平,而Deepfake模型产生的深度伪造视频却已经崩坏,无法以假乱真,其对Deepfake带来影响是灾难性的。

但当改为通过MagDR框架进行处理时,情况发生了变化。该模型首先对视频中的对抗攻击扰动进行检测,提醒Deepfake的使用者,所用的图片或视频是大概率存在对抗攻击的情况的,然后通过重建视频模型,能够有效地将攻击者注入的对抗扰动进行消除,从而实现了Deepfake模型相关系统的正常使用。

MagDR框架不仅能够消除对抗扰动带来的破坏性影响,同时还保留了原图的各种像素细节,进而保证了重建后的Deepfake结果与原图结果一致。

这一发现表明,原先业界主流的主动性防御的方法(Deepfake对抗扰动)不再可靠,为了避免社交网络上人脸照片被恶意使用,还需要找到更佳的Deepfake防御方案。

同时,腾讯Blade Team研究员也在此发现的基础上提出了安全建议,比如可以生成特定的对抗扰动,使得产生出的崩坏效果受到限制,更加真实以绕过目前MagDR的检测,或者说产生更难以被重建模块消除的鲁棒性对抗扰动。

研究员同时提出,希望大家可以对MagDR的组件或者整体结构进行调整与创新,以其作为新思路的创新点,产生出更为强大的防御框架,从而防止Deepfake的恶意滥用,进一步地加强用照片或视频的安全性。技术在不断进步,只有“用AI对抗AI”,才能让技术的安全应用走得更远。

来源:freebuf.com 2021-04-01 11:45:01 by: 腾讯

请登录后发表评论

注册