当给数据中植入人类觉察不到的微弱“干扰”时,神经网络可能就会把乌龟看成来福枪,无人车会无视停止标志,智能音箱就会执行隐藏命令。

研究者已发现在某些AI模型的输入上增加少量“干扰”,这种经过处理后的输入样本通常被称为对抗样本,可在人类无法分辨区别的情况下使模型对输入的分类结果做出错误判断。

当今AI成为各个安全公司驱动安全能力提升的新“引擎”,很多产品在利用AI最大程度上提升安全检测和防护能力。同时,AI本身的安全问题也浮出水面,在RSAC 2019 上,AI可能带来的安全挑战及其解决方案成为讨论热点。

AI本身是安全的吗?

人脸识别、智慧城市、智能家居等都在运用AI,但一旦后端控制系统被攻击,出现规模化、连锁式的崩盘,AI失控的后果不堪设想。AI应用本身(包括AI系统、AI模型、AI数据)也面临来自多个方面的威胁,这些威胁可能导致AI所驱动的识别系统出现混乱,形成漏判或者误判,甚至导致系统崩溃或被劫持,并可以使智能设备变成 僵尸攻击工具。

1.AI系统本身存在实现漏洞,并不安全

目前AI学习框架多是TensorFlow、Caffe等,可以说是当下AI开发者与研究者的标准配置,但这些平台却纷纷被爆出存在安全漏洞和被黑客利用的可能性。这些框架隐藏了其后面的复杂性和其所用的组件依赖,所以极有可能包含安全隐患,任何在AI学习框架以及它所依赖的组件中的安全问题都会威胁到框架之上的应用系统。目前已经发现了很多AI学习框架及其依赖库中的软件漏洞,包括了几乎所有常见的类型,这些漏洞潜在带来的危害可以导致对AI应用潜在的数据污染攻击、逃逸攻击等。

绿盟科技 天机实验室专注于漏洞挖掘与利用技术研究,天机实验室发现:利用TensorFlow本身的系统漏洞,黑客可以很容易的制造恶意模型,从而控制、篡改使用恶意文件的AI应用。面对更多未知的漏洞和危险,AI开发者近乎是束手无策。

2.用数据污染的手段攻击AI应用

《连线》英国版聚焦了用数据污染AI可能造成的影响——比如说微软小冰,它是一个人工智能对话系统,刚上线的时候因为用实时对话的数据进行训练的,所以你给他一些不好的对话,就会被污染,这是非常直观的。

研究发现攻击者可以用数据污染脸部检测算法,令其将攻击者的脸识别成获授权的人的脸。目前传统的网络安全所构建的安全防御体系,虽然能够防御黑客的入侵和渗透,但显然并不能防止脏数据或者数据污染。

如何构建安全的AI?

在推进AI应用的同时,我们迫切需要关注并解决这些安全问题。目前大部分安全聚焦用AI来做应用安全防护,包括安全检测和弱智能化的安全防护。

下面给出了此次RSAC上针对AI本身的安全问题的部分解决方案:

1)区块链的引入

区块链是安全、分布式、恒定的数据库,由分布式网络的各方所共享,这个数据库可以记录交易数据,审计起来也很容易。

区块链技术用来解决数据污染等问题。有一个清晰的审计跟踪不仅可以提高数据的可信性,还可以提高模型的可信度,也为追溯机器决策过程提供了一条清晰的途径。

2)提高可解释性

目前由于AI算法内部的运作往往是不透明的,AI的黑箱问题和可解释性问题越来越受到关注。深度学习方面的最大挑战之一是向客户和监管机构解释模型是如何得到答案的,但根本不知道模型是如何得到答案的。

然而在《通用数据保护条例》(GDPR)严格监管的时代,这种黑盒子似的预测计算根本不足以满足要求,这正促使很多公司开发可解释型AI(XAI)。XAI 用于解释人工智能所做出的每一个决策背后的逻辑推理,有助于找到数据和特征行为中的问题。

3)基于AI的安全系统的安全性评估系统

设计新的安全框架来衡量和量化基于AI的安全系统。在该安全系统中需要能够解决:评估数据是否被有意污染,引入第三方数据时是否会导致无意的数据污染,AI给出不可靠信息如何评估,是否自动化回应AI推荐的决策并采取行动等。学术界和工业界都在开展研究,AI作为一种手段,可以降维打击传统攻击,抵抗同级的AI攻击,但是要在实际场景中大规模应用还需要做大量工作,现在AI还只是弱 智能化,适合加以利用做辅助决策。

对网络安全行业来说,“AI是手段,安全是目标”,用AI做安全检测和防护同时,也要考虑构建安全的AI。

*本文作者:NSFOCUS,转载请注明来自FreeBuf.COM

来源:freebuf.com 2019-03-15 15:39:38 by: NSFOCUS

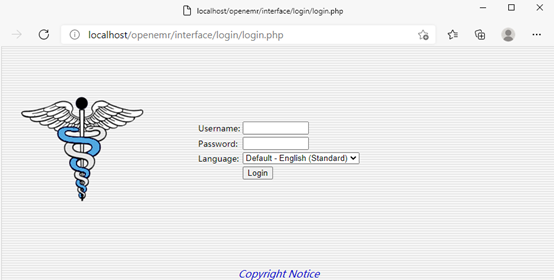

请登录后发表评论

注册