这是一篇转载文章.

学用python也有3个多月了,用得最多的还是各类爬虫脚本:写过抓代理本机验证的脚本,写过在discuz论坛中自动登录自动发贴的脚本,写过自动收邮件的脚本,写过简单的验证码识别的脚本,本来想写google music的抓取脚本的,结果有了强大的gmbox,也就不用写了。

–

这些脚本有一个共性,都是和web相关的,总要用到获取链接的一些方法,再加上simplecd这个半爬虫半网站的项目,累积不少爬虫抓站的经验,在此总结一下,那么以后做东西也就不用重复劳动了。

–

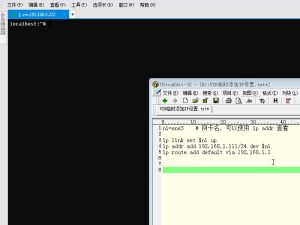

1.最基本的抓站

import urllib2

content = urllib2.urlopen('http://XXXX').read()

如chrome浏览器F12呼出控制台,粘贴以下代码回车,提示输出刷新的时间间隔就可以开始自动刷新了。 timeout=prompt(“Set timeout (Second):”); count=0 current=location.href; if(time…

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

喜欢就支持一下吧

请登录后发表评论

注册